Este es mi elogio oficial para la palabra clave SEO, que murió hace muchos años, pero nadie lo ha notado.

Como resultado, muchos equipos de marketing toman decisiones por debajo del par, y los tomadores de decisiones pierden confianza en el SEO como canal. Solo mira las recientes reacciones “SEO is Dead” a la disminución del tráfico de Hubspot.

Google aplica a JavaScript para rastrear

Desde el 20 de enero, Google ha requerido JavaScript para la búsqueda, lo que hace que el seguimiento de rango sea más costoso.

Este es el último movimiento en una batalla de larga data entre SEO Pros y Google.

Los rastreadores de rango (Semrush, Ahrefs, Seomonitor, etc.) han estado operando en una zona gris. Google los tolera pero oficialmente no lo permite.

Ahora, con JavaScript como un requisito difícil, el seguimiento de rango necesita más RAM, lo que aumenta el costo de cada punto de datos.

El resultado es que el costo de hacer SEO está aumentando. Pero el seguimiento de rango perdió su valor mucho antes de que Google cambiara a JavaScript Grawling.

Centrarse en palabras clave únicas no ha tenido sentido en mucho tiempo

Con todos los elementos en los SERP y los datos no representativos que obtenemos, es difícil proyectar el impacto y medir el éxito puramente basado en rangos de palabras clave.

- En 2013, Google dejó de compartir referentes de palabras clave. La única forma de comprender qué buscaban los usuarios para llegar a su sitio fue y seguir siendo la consola de búsqueda de Google.

- En 2014, Google comenzó a mostrar fragmentos destacados, respuestas directas en la parte superior de los resultados de búsqueda, lo que creó más situaciones de ganadores-tomas-it-todo. Las características de SERP posteriores como las personas también pidieron o los carruseles de video siguieron y subieron de rango. Hoy, más de 30 características de SERP conocidas compiten por la atención con resultados de búsqueda clásicos. Es muy difícil predecir cuántos clics puede obtener porque hay muchas combinaciones de características de SERP.1

- Desde el año pasado, Google ha mostrado anuncios para resultados orgánicos y ha roto la separación tradicional entre los resultados orgánicos y pagados.

- Y, por supuesto, el año pasado, Google lanzó vistas a la IA. Las respuestas de IA ahora están disponibles en más de 100 países y proporcionan respuestas en profundidad. Hacer clic en los resultados de búsqueda ahora es redundante en algunos casos.

- Los datos que Google comparte alrededor de estas tendencias varían de inexistentes a desnudos. Las descripción general de la IA o las características de SERP no se incluyen en los datos de la consola de búsqueda. Ni siquiera hablando del hecho de que Google filtra el 50% de los datos de consultas por “razones de privacidad”: AHREFS analizó 150,000 sitios web y descubrió que aproximadamente el 50% de las palabras clave y los clics están ocultos.2

Por un lado, una sola página web puede clasificarse para miles de palabras clave siempre que esas palabras clave expresen la misma intención y la página brinde una buena respuesta a todas las preguntas implícitas. Este ha sido el caso durante muchos años.

Por otro lado, cada vez más palabras clave no entregan tráfico porque todos los clics van a una función SERP que mantiene a las personas en los resultados de búsqueda, o un clic no es necesario: los buscadores obtienen la respuesta en los resultados de búsqueda.

SparkToro descubrió que el +37% de las búsquedas terminan sin hacer clic, y +21% da como resultado otra búsqueda.3

Crédito de la imagen: Kevin Indig

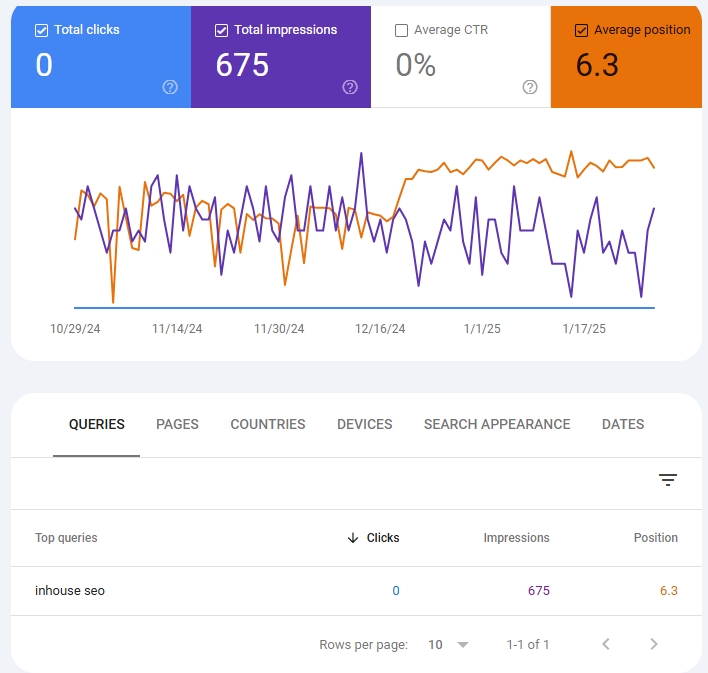

Crédito de la imagen: Kevin IndigHace un par de meses, reescribí mi guía para el SEO interno y comencé a clasificar en la posición uno. Pero la broma estaba sobre mí. No obtuve un solo clic sucio para esa palabra clave.

Más de 200 personas buscan [inhouse seo]pero ni una sola persona hace clic en un resultado de búsqueda.

Por cierto, Google Analytics solo muestra 10 clics de la búsqueda orgánica en los últimos tres meses.

Entonces, ¿qué está pasando? Los 10 clics que realmente tengo no se informan en GSC (¿privacidad … supongo?), Pero la mayoría de los buscadores probablemente hagan clic en una de las personas que también preguntaron características que aparecen por debajo de mi resultado de búsqueda.

La imagen más grande es que el valor de las palabras clave y las filas se ha derrumbado.

Nuestra respuesta puede ser doble:

- Primero, si bien el objetivo general aún debe ser clasificarse en la parte superior, debemos apuntar al elemento que es más probable que reciba toda la atención en los SERP, como carruseles de video o respuestas de IA. En algunos casos, eso significa expandir el “SEO” a otras plataformas como YouTube.

- En segundo lugar, debemos analizar los datos agregados.

Tráfico agregado> Palabras clave

Todavía estamos operando con el antiguo modelo de SEO, que es donde rastreamos una lista de palabras clave para medir el éxito y establecer objetivos.

Pero, ¿cuánto sentido tiene eso, las páginas dadas se clasifican para muchas palabras clave? ¿Cuánto sentido tiene una búsqueda dada para pasar de una lista de resultados a las respuestas de LLM?

La palabra clave no tiene futuro en la búsqueda. Lo que hace es intención, y los LLM son mucho mejores para comprenderlo.

Entonces, aquí está mi sugerencia: en lugar de centrarnos en las palabras clave, debemos centrarnos en el tráfico orgánico agregado en la página o el nivel de dominio.

Algunas trampas para tener en cuenta:

- Todavía necesitamos palabras clave para modelar el tráfico de marca frente a la no marca por página (todavía funciona porque debe tener suficientes palabras clave).

- Tenga cuidado con la estacionalidad.

- Divida el tráfico orgánico por nuevas páginas vs. existentes.

Para rastrear qué tan bien está funcionando un dominio o página, aún podemos mirar las palabras clave; La dirección del tráfico orgánico es más indicativo de si funciona bien o no.

Un gran problema que tengo con las palabras clave es que el volumen de búsqueda tiene muchos defectos y no es representativo de lo que realmente está sucediendo.

El término “SEO interno” tiene un volumen de búsqueda reportado de 90-200 en los rastreadores de rango más grandes, pero en realidad no ofrece ningún clic.

Para saber qué páginas crear sin investigación de palabras clave, hablar con los clientes y analizar qué temas y preguntas les importan.

Analice plataformas como Reddit y YouTube para participación e ingeniería inversa de lo que funcionan los temas.

Y, podemos, y probablemente tendremos que usar los datos de búsqueda pagados para informar SEO porque refleja más los temas con la forma en que Google muestra los anuncios (Performance Max) a los usuarios en búsqueda, que son similares a la intención del usuario.

Para proyectar el tráfico, mire los dominios o páginas que ya están visibles para temas que nos importan, pero no en el nivel de palabras clave.

Los datos de Clickstream que reflejan cómo los usuarios navegan por la Web es mucho mejor porque no proyecta el tráfico potencial en función de una posición de palabra clave.

Donde las palabras clave aún hacen (algún sentido) es para analizar el volumen de búsqueda histórica para proyectar si un tema está creciendo o reduciendo, pero sugiero usar solo grandes cantidades de palabras clave.

Un gran beneficio del enfoque de tráfico agregado es que transfiere bien a LLM porque tampoco nos dan consultas, pero podemos rastrear el tráfico de referencia en el dominio y el nivel de página.

ChatGPT incluso agrega un parámetro URL a los clics salientes que facilita el seguimiento.

Defensa de LLM: activado

Crédito de la imagen: Kevin Indig

Crédito de la imagen: Kevin IndigLa verdadera razón por la que Google aplica JavaScript Grastling es dañar a los profesionales de SEO, sino a los competidores de Genai.

El chatgpt y la perplejidad están ganando un terreno significativo. ChatGPT ya ha superado el tráfico de Bing y Gemini de Google. La perplejidad está en camino.

Sin embargo, los rastreadores de LLM no pueden ejecutar JavaScript, lo que significa que ahora ya no pueden rastrear los resultados de búsqueda de Google para fundamentar sus respuestas.

(Por cierto, debe asegurarse de que su contenido sea accesible sin JavaScript. De lo contrario, los LLM no pueden rastrearlo, y no puede aparecer en sus respuestas).

La calidad de algunos LLM podría disminuir debido a que Google impulsa a JavaScript, pero solo temporalmente. LLMS aún puede obtener datos SERP de otras maneras.

Pero una consecuencia potencial de la decisión de Google es que los desarrolladores de LLM crean sus propios modelos o índices web para sopesar las respuestas y se independizan de los motores de búsqueda.

El efecto de segundo orden de eso sería que ya no es suficiente para hacer un buen SEO para aparecer en LLMS. Tendríamos que revertir los resultados de LLM de ingeniería como lo hicimos con Google.

Si SEO es un juego, ganar en SEO ahora requiere ajustar basado en el flujo (intención) del juego en lugar de contar cartas (palabras clave).

El futuro de la búsqueda no son palabras clave sino intenciones.

Que este sea mi elogio oficial.

Crédito de la imagen: Kevin Indig

Crédito de la imagen: Kevin Indig1 Sensor de semrush

2 Casi la mitad de los clics GSC van a los términos ocultos: un estudio de Ahrefs

3 Estudio de búsqueda de clic cero 2024

Imagen destacada: Paulo Bobita/Search Engine Journal

Con información de Search Engine Journal.

Leer la nota Completa > Por qué el tráfico orgánico agregado es una mejor métrica